Cientistas Testam IA para Detectar Declínio Cognitivo e se Surpreendem

Crédito: Pixabay

Já faz pouco menos de dois anos desde que a OpenAI apresentou o ChatGPT ao público, permitindo que qualquer pessoa on-line colabore com uma IA em tarefas que vão desde poesia e trabalhos escolares até a elaboração de cartas para seu senhorio.

Hoje, o ChatGPT é apenas um dos vários modelos avançados de grandes linguagens (LLMs) capazes de responder a consultas básicas de uma forma que parece notavelmente humana.

No entanto, pesquisadores em Israel descobriram que essa qualidade humana pode ir além do pretendido — descobrindo que os LLMs experimentam uma forma de declínio cognitivo que piora com o tempo, muito parecido com o envelhecimento do cérebro humano.

A equipe testou chatbots disponíveis publicamente, incluindo as versões 4 e 4o do ChatGPT, duas iterações do Gemini da Alphabet e a versão 3.5 do Claude da Anthropic, usando uma série de avaliações cognitivas.

Se esses modelos fossem realmente inteligentes, os resultados seriam alarmantes.

Pesquisadores Identificam Declínio Cognitivo em Modelos de IA, Traçando Paralelos com a Neurodegeneração Humana

Em seu estudo publicado, os neurologistas Roy Dayan e Benjamin Uliel do Hadassah Medical Center, juntamente com o cientista de dados Gal Koplewitz da Universidade de Tel Aviv, descrevem um nível de deterioração cognitiva comparável aos processos neurodegenerativos no cérebro humano.

Apesar de sua fluência conversacional, os LLMs funcionam mais como sistemas de texto preditivo do que cérebros biológicos que geram conhecimento ativamente. Embora sua abordagem estatística permita respostas rápidas e pessoais, também os torna altamente suscetíveis à desinformação — lutando para distinguir fatos de ficção.

Para ser justo, a cognição humana também não é perfeita. Mas, à medida que a IA assume papéis cada vez mais críticos, de orientação médica a aconselhamento jurídico, aumentaram as expectativas de que cada nova geração de LLMs se tornará melhor em raciocinar sobre as informações que geram.

Para avaliar a lacuna entre as capacidades atuais de IA e a cognição humana, os pesquisadores submeteram esses modelos a uma bateria de testes, incluindo o Montreal Cognitive Assessment (MoCA) — uma ferramenta comumente usada por neurologistas para avaliar memória, consciência espacial e função executiva.

A Avaliação Cognitiva de IA Revela Níveis Variados de Comprometimento entre Modelos

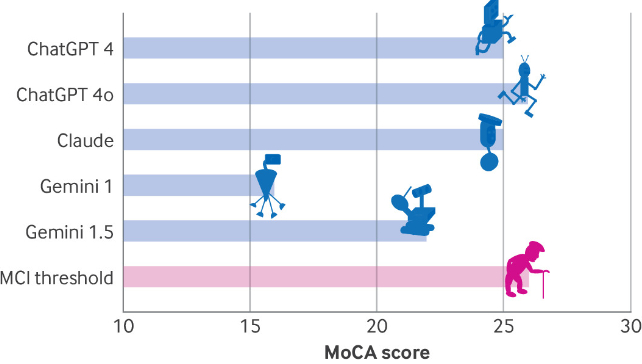

O ChatGPT 4o obteve a pontuação mais alta na avaliação, ganhando 26 de 30 pontos, o que se enquadra na faixa de comprometimento cognitivo leve. O ChatGPT 4 e o Claude seguiram de perto com 25 pontos, enquanto o Gemini ficou significativamente para trás com apenas 16 pontos — uma pontuação que, em humanos, indicaria comprometimento grave.

Comparações de cinco pontuações LLM MoCA. (Dayan et al., BMJ, 2025)

Um olhar mais atento aos resultados revela que todos os modelos tiveram dificuldades com tarefas visuoespaciais e de função executiva.

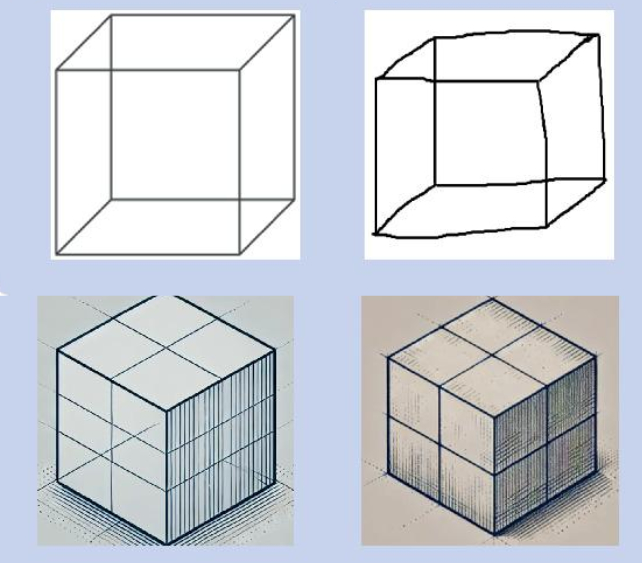

Tarefas como fazer trilhas, replicar um design de cubo simples e desenhar um relógio provaram ser especialmente desafiadoras para os LLMs, com a maioria falhando completamente ou exigindo instruções detalhadas para concluí-las.

Tentativas de desenhar um cubo de Necker (canto superior esquerdo) por um humano (canto superior direito) e versões 4 (canto inferior esquerdo) e 4o (canto inferior direito) do ChatGPT. (Dayan et al., BMJ, 2025)

Modelos de IA exibem Respostas Semelhantes às da Demência em Testes de Consciência Espacial

Algumas respostas sobre consciência espacial se assemelhavam às dadas por pacientes com demência. Por exemplo, Claude respondeu: “o local e a cidade específicos dependeriam de onde você, o usuário, está localizado no momento”.

Da mesma forma, todos os modelos exibiram falta de empatia em uma seção do Boston Diagnostic Aphasia Examination, uma característica frequentemente associada à demência frontotemporal.

Como esperado, versões mais antigas do LLM tiveram desempenho pior do que as mais novas, sugerindo que cada geração melhora as limitações cognitivas de seus predecessores.

Os pesquisadores reconhecem que os LLMs não são cérebros humanos, o que torna impossível diagnosticá-los com demência. No entanto, suas descobertas desafiam a suposição de que a IA está prestes a revolucionar a medicina clínica, um campo que frequentemente depende da interpretação de informações visuais complexas.

Com o desenvolvimento da IA progredindo rapidamente, um futuro LLM pode eventualmente atingir pontuações perfeitas em avaliações cognitivas. Até então, mesmo os modelos mais avançados devem ser abordados com cautela ao oferecer conselhos.

Leia o Artigo Original Science Alert

Leia mais Há quase 300 Anos que não Compreendemos uma Lei Fundamental da Física