O Modelo Depth Pro da Apple Cria Mapas 3D a Partir de Imagens 2D em Segundos

“Depth Pro sintetiza mapas de profundidade de alta resolução com nitidez incomparável e detalhes de alta frequência.”

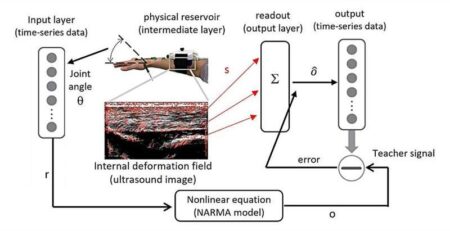

A equipe de Pesquisa de Aprendizado de Máquina da Apple criou um modelo de IA fundamental para “estimativa de profundidade monocular métrica zero-shot.” O Depth Pro permite a geração rápida de mapas detalhados de profundidade 3D a partir de uma única imagem 2D.

Nossos cérebros interpretam informações visuais a partir de duas fontes — nossos olhos. Cada olho captura uma perspectiva ligeiramente diferente do mundo, e essas visões se fundem em uma única imagem estéreo, com as variações ajudando na percepção da distância dos objetos.

Muitas câmeras e smartphones usam uma única lente para capturar imagens, mas os desenvolvedores podem criar mapas de profundidade 3D utilizando metadados de fotos 2D (como distâncias focais e detalhes do sensor) ou analisando várias imagens.

No entanto, o sistema Depth Pro evita esses métodos e pode gerar um mapa de profundidade 3D detalhado em 2,25 megapixels a partir de apenas uma imagem em 0,3 segundos, utilizando uma unidade de processamento gráfico padrão.

Arquitetura do Modelo de IA e Estimativa de Profundidade

A arquitetura do modelo de IA conta com um transformador de visão multi-escala que processa tanto o contexto geral de uma imagem quanto detalhes finos, como cabelo, pelos e outras estruturas complexas. Ele pode estimar tanto a profundidade relativa quanto a absoluta, permitindo que aplicações como realidade aumentada posicionem com precisão objetos virtuais em espaços físicos.

Essa IA atinge esses resultados sem exigir um treinamento intensivo em conjuntos de dados específicos, utilizando uma técnica conhecida como aprendizado zero-shot — definida pela IBM como uma abordagem de aprendizado de máquina em que uma IA pode reconhecer e categorizar classes não vistas sem exemplos rotulados. Isso a torna bastante adaptável.

Potenciais Aplicações do Depth Pro

Em termos de aplicações, além das capacidades mencionadas de AR, o Depth Pro pode aprimorar a eficiência na edição de fotos, facilitar imagens 3D em tempo real com uma câmera de lente única e ajudar veículos autônomos e robôs a perceberem seus arredores de maneira mais eficaz em tempo real.

O projeto está atualmente na fase de pesquisa, mas, de forma incomum para a Apple, o código e a documentação de suporte estão sendo lançados como open source no GitHub. Isso permite que desenvolvedores, cientistas e programadores avancem ainda mais a tecnologia.

Os pesquisadores publicaram um artigo detalhando o projeto no servidor Arxiv, e eles oferecem uma demonstração ao vivo para quem estiver interessado em experimentar a versão atual.

Leia o Artigo Original New Atlas

Leia mais Cubo de Visualização Apagável Mostra Imagens 2D, 3D e Animadas