IA Supera os Humanos na Maioria dos Parâmetros de Desempenho

O Instituto de Inteligência Artificial Centrada no Ser Humano (HAI) da Universidade de Stanford publicou a sétima edição do seu extenso relatório Índice de IA, da autoria de um grupo diversificado de especialistas académicos e da indústria.

Esta última edição, mais abrangente do que as anteriores, sublinha o rápido avanço e a crescente relevância da IA no nosso quotidiano. Aborda vários tópicos, desde os sectores que mais tiram partido da IA até aos países mais preocupados com a deslocação de empregos devido à IA. No entanto, uma descoberta de destaque do relatório é o desempenho da IA em comparação com os humanos.

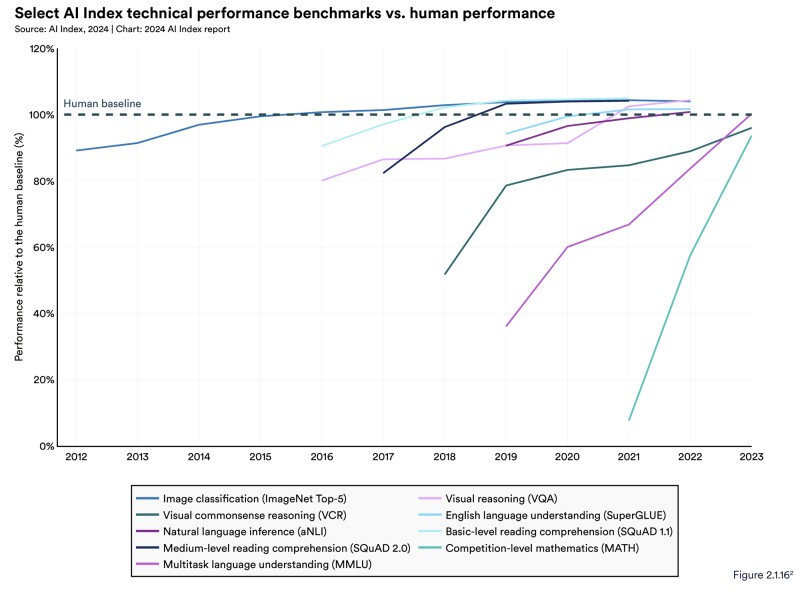

Para quem não tem estado a par, a IA já nos ultrapassou numa gama surpreendentemente vasta de tarefas importantes. Começou com a classificação de imagens em 2015, seguida da compreensão básica de leitura em 2017, do raciocínio visual em 2020 e da inferência de linguagem natural em 2021.

Adaptar-se ao Rápido Progresso da IA

O ritmo a que a IA está a avançar é notável, tornando desactualizados muitos dos parâmetros de referência existentes. Os investigadores neste domínio estão agora a correr para criar novos e mais complexos parâmetros de referência. Essencialmente, as IA estão a tornar-se tão hábeis a passar nos testes que agora precisamos de novas avaliações – não para avaliar a competência, mas para identificar áreas onde os humanos ainda se destacam e onde mantemos uma vantagem.

É importante mencionar que os resultados seguintes se baseiam nestas referências potencialmente desactualizadas. No entanto, a tendência geral continua a ser inconfundível:

Índice de IA 2024

Examine essas tendências, especialmente a linha quase vertical nos testes mais recentes. Tenha em mente que estas máquinas estão essencialmente na sua infância.

O último relatório do Índice de IA destaca que, em 2023, a IA ainda enfrentava dificuldades com tarefas cognitivas complexas, como a resolução de problemas matemáticos avançados e o raciocínio visual de senso comum.

No entanto, descrever isto como “dificuldades” pode ser enganador; não implica um mau desempenho.

Progressos Notáveis da IA na Resolução de Problemas Matemáticos Complexos

No conjunto de dados MATH, que inclui 12.500 problemas matemáticos desafiantes ao nível da competição, o desempenho da IA registou uma melhoria notável desde o seu início. Em 2021, os sistemas de IA só conseguiram resolver 6,9% desses problemas. Em contraste, em 2023, um modelo baseado no GPT-4 resolveu com sucesso 84,3%. A linha de base humana é de 90%.

E não estamos a referir-nos à pessoa comum; estamos a falar de indivíduos capazes de resolver questões como estas:

Hendryks et al./Índice de IA 2024

Este é o estado da matemática avançada em 2024, e ainda estamos na fase inicial da era da IA.

Raciocínio Visual de Senso Comum (VCR)

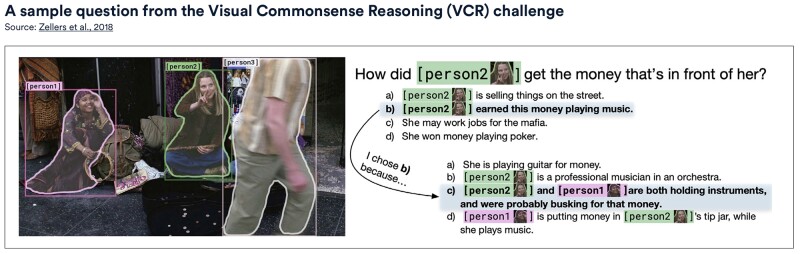

Depois há o raciocínio visual de senso comum (VCR). Ao contrário do reconhecimento básico de objectos, o VCR avalia a forma como a IA utiliza o conhecimento do senso comum em cenários visuais para fazer previsões.

Por exemplo, quando lhe é apresentada a imagem de um gato em cima de uma mesa, uma IA equipada com VCR deve prever que o gato pode saltar da mesa ou reconhecer que a mesa pode suportar o seu peso.

O relatório revelou uma melhoria de 7,93% no VCR de 2022 a 2023, atingindo uma pontuação de 81,60, em comparação com a linha de base humana de 85.

Zellers et al./AI Index 2024

Há cinco anos, a ideia de apresentar uma imagem a um computador e esperar que ele compreendesse o contexto suficientemente bem para dar uma resposta teria parecido rebuscada.

Atualmente, a IA produz conteúdos escritos em vários domínios. No entanto, apesar dos avanços significativos, os grandes modelos de linguagem (LLM) ainda produzem, por vezes, o que é eufemisticamente designado por “alucinações”. Isto significa, essencialmente, que podem ocasionalmente apresentar informações incorrectas ou enganosas como se fossem factuais.

Os Riscos do Excesso de Confiança na IA

Um incidente notável que ilustra este facto ocorreu no ano passado, envolvendo Steven Schwartz, um advogado de Nova Iorque que confiou no ChatGPT para investigação jurídica sem verificar a informação. O juiz que supervisionava o caso identificou casos legais fabricados nos documentos gerados pela IA e multou Schwartz em 5.000 dólares (7.750 dólares australianos) pela sua negligência. Este incidente chamou a atenção a nível mundial.

O HaluEval serve de referência para avaliar estas tendências de alucinação. Os testes revelaram que muitos LLMs ainda se debatem com esta questão.

A IA generativa também enfrenta desafios para garantir a veracidade. O último relatório do Índice de IA utilizou o TruthfulQA como métrica para avaliar a exatidão dos LLM. Esta referência consiste em 817 perguntas que abrangem tópicos como saúde, direito, finanças e política, com o objetivo de testar e corrigir equívocos comuns que os humanos têm frequentemente.

O GPT-4, lançado no início de 2024, obteve a pontuação mais alta neste benchmark com uma pontuação de 0,59, quase três vezes melhor do que um modelo baseado em GPT-2 avaliado em 2021. Esta melhoria significativa sugere que os LLMs estão a avançar de forma constante no fornecimento de respostas precisas.

Quanto às imagens geradas por IA, para apreciar o notável progresso na geração de texto para imagem, podemos olhar para as tentativas da Midjourney de ilustrar o Harry Potter desde 2022:

Midjourney/AI Index 2024

Isso representa quase dois anos de avanço da IA. De quanto tempo acha que um artista humano precisaria para atingir uma proficiência comparável?

A Avaliação Holística de Modelos de Texto para Imagem (HEIM) foi utilizada para avaliar as competências de geração de texto para imagem dos LLM, centrando-se em 12 aspectos críticos essenciais para a aplicação prática de imagens.

Avaliação de Imagens Geradas por IA

Os avaliadores humanos avaliaram as imagens geradas e verificaram que nenhum modelo se destacava em todos os critérios. O DALL-E 2 da OpenAI teve o melhor desempenho no alinhamento entre imagem e texto, ou seja, a correspondência entre a imagem e o texto fornecido. O modelo Dreamlike Photoreal, baseado em difusão estável, foi o mais bem classificado em termos de qualidade (semelhança com uma foto), estética (apelo visual) e originalidade.

O Relatório do próximo ano promete ser incrivelmente excitante.

Vale a pena notar que este Relatório do Índice de IA termina no final de 2023, um ano marcado por intensos avanços de IA e rápido progresso. No entanto, 2024 provou ser ainda mais agitado, testemunhando a introdução de desenvolvimentos inovadores como Suno, Sora, Google Genie, Claude 3, Channel 1 e Devin.

Cada uma destas inovações, juntamente com várias outras, tem o potencial de transformar fundamentalmente sectores inteiros. Além disso, a pairar sobre todos estes avanços está a presença enigmática do GPT-5, que poderá ser um modelo tão abrangente e versátil que poderá ofuscar todos os outros.

A IA veio, sem dúvida, para ficar. O ritmo acelerado dos avanços tecnológicos observados ao longo de 2023, conforme destacado neste relatório, indica que a IA continuará a avançar, diminuindo a distância entre humanos e tecnologia.

Entendemos que isto é bastante para assimilar, mas há mais para explorar. O relatório analisa os desafios que acompanham a progressão da IA e o seu impacto na perceção global da sua segurança, fiabilidade e ética. Fique atento à segunda parte desta série, em breve!

Leia O Artigo Original: New Atlas

Leia Mais: A Inteligência Artificial Pode Trazer o Fim da Civilização?