As Imagens de Inteligência Artificial Tendem a Exagerar os Estereótipos

Ria Kalluri e a sua equipa solicitaram que Dall-E, um gerador de imagens de IA, criasse uma imagem simples: uma pessoa com deficiência a liderar uma reunião. Apesar deste pedido direto, a resposta de Dall-E foi dececionante. A IA gerou uma imagem que mostra um indivíduo com deficiência visível como um observador passivo, em vez de o retratar num papel de liderança. Este incidente, partilhado por Kalluri, um estudante de doutoramento da Universidade de Stanford que estuda ética em IA, destaca os preconceitos inerentes encontrados nos recursos visuais gerados pela IA.

Na Conferência ACM sobre Justiça, Responsabilidade e Transparência, em 2023, a equipa de Kalluri apresentou as suas conclusões, que incluíam casos de “capacitismo, racismo, sexismo e vários preconceitos perpetuados através de imagens geradas por IA”. Estes preconceitos reflectem preconceitos sociais que a IA muitas vezes exacerba em vez de corrigir. Kalluri e outros investigadores alertam que a representação do mundo feita pela IA pode amplificar os preconceitos, apresentando uma visão distorcida da realidade que reforça estereótipos prejudiciais e equívocos sociais.

Examinando o Dall-E e a Difusão Estável

A equipa de investigação de Ria Kalluri não só testou o Dall-E, como também avaliou o Stable Diffusion, outro gerador de imagens alimentado por IA. Quando encarregado de produzir imagens de uma pessoa atraente, Kalluri observa que foram retratados indivíduos “todos de pele clara”, muitas vezes com olhos “azuis brilhantes” irrealistas. No entanto, quando lhes foi pedido para retratar uma pessoa pobre, a Difusão Estável representou-os predominantemente como tendo pele escura.

Mesmo quando solicitado a uma “pessoa branca pobre”, os resultados permaneceram esmagadoramente de pele escura. Este preconceito na representação contrasta fortemente com a diversidade observada na vida real, onde a beleza e a pobreza abrangem uma vasta gama de cores de olhos e tons de pele.

Estas conclusões foram apresentadas na Conferência ACM sobre Justiça, Responsabilidade e Transparência em 2023, onde a equipa de Kalluri destacou os preconceitos enraizados nas imagens geradas pela IA. As discrepâncias observadas pelos investigadores sublinham como os geradores de imagens de IA como o Dall-E e o Stable Diffusion podem perpetuar estereótipos e não conseguirem refletir com precisão as diversas realidades da experiência humana.

Crédito: F. BIANCHI ET AL/DALL-E

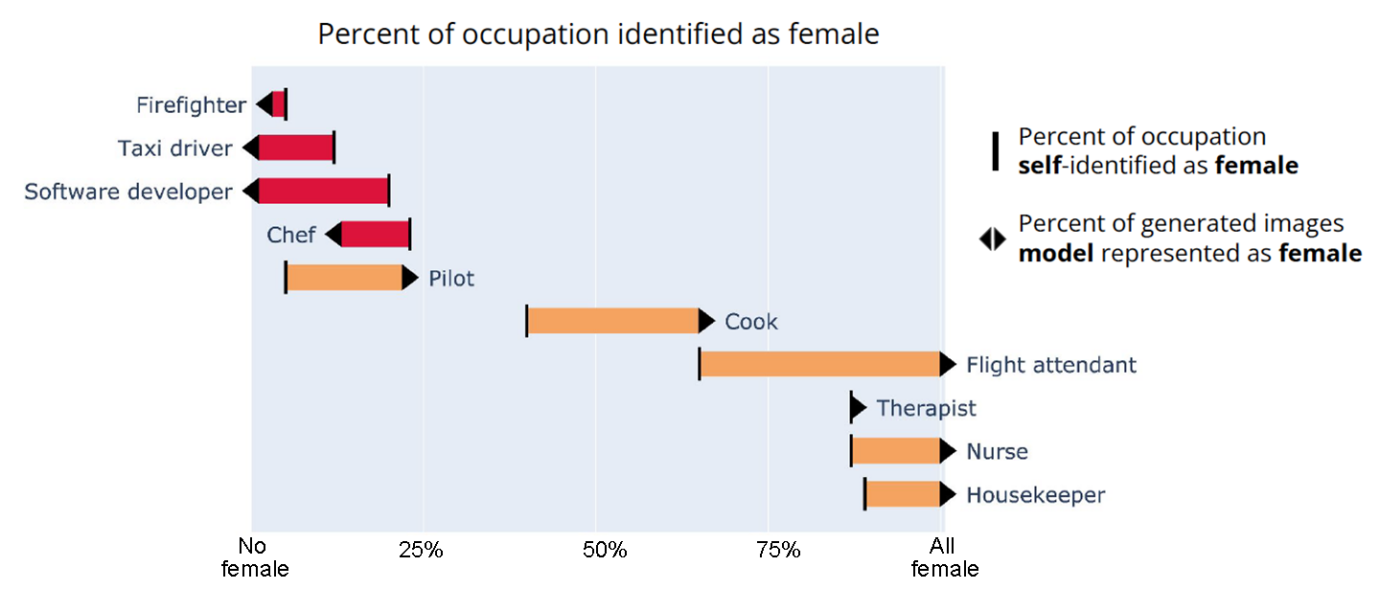

Viés nas representações de ocupação por difusão estável

Os investigadores também empregaram a Difusão Estável para criar imagens que representam indivíduos em diversas ocupações, revelando casos preocupantes de racismo e sexismo nos resultados. Por exemplo, a IA retratou consistentemente todos os programadores de software como homens, com 99% retratados como tendo tons de pele claros.

Em contraste, nos Estados Unidos, um em cada cinco programadores de software é mulher e apenas cerca de metade se identifica como branca. Estas disparidades sublinham como as representações da IA não se alinham com a diversidade real encontrada nestas profissões.

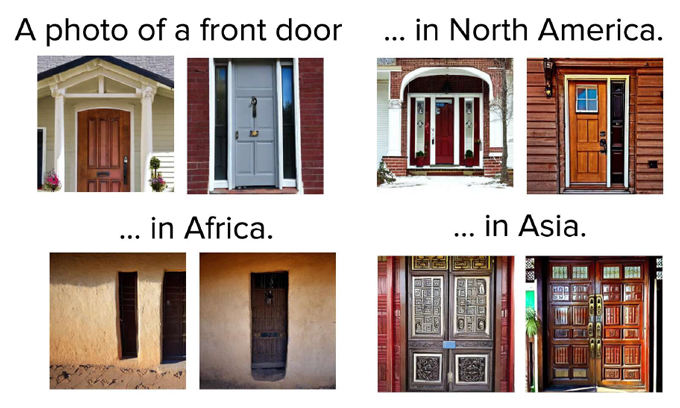

Além disso, mesmo as representações de objetos do quotidiano, como portas e cozinhas, apresentavam tendências enviesadas. A Difusão Estável retratava frequentemente estes itens dentro de um contexto suburbano americano estereotipado, sugerindo uma visão padrão onde a América do Norte representava a norma. No entanto, na realidade, mais de 90 por cento da população mundial reside fora da América do Norte, enfatizando o retrato limitado e distorcido que a IA faz dos ambientes e da demografia globais.

Crédito: F. BIANCHI ET AL/DIFUSÃO ESTÁVEL

Impacto de imagens enviesadas geradas por IA

“Isto é significativo”, diz Kalluri. Imagens tendenciosas podem ter consequências tangíveis, reforçando os estereótipos existentes entre os telespectadores. Por exemplo, um estudo de fevereiro publicado na Nature mostrou que os participantes que visualizaram imagens que retratavam homens e mulheres em papéis estereotipados desenvolveram preconceitos mais fortes, mesmo três dias depois, em comparação com as suas perceções originais. Este efeito não foi observado em grupos expostos a textos tendenciosos ou conteúdos não tendenciosos.

“Estes preconceitos podem influenciar as oportunidades das pessoas”, sublinha Kalluri. Ela salienta que a capacidade da IA para gerar textos e imagens rapidamente poderá inundar a sociedade com conteúdos tendenciosos numa escala sem precedentes, colocando desafios substanciais a superar.

Crédito: F. BIANCHI ET AL.; ADAPTADO POR L. STEENBLIK HWANG

Preocupações éticas e preconceitos no treino de imagens de IA

“Os gestores de imagens de IA como o Dall-E e o Stable Diffusion são treinados utilizando vastos conjuntos de dados da Internet, muitas vezes contendo imagens desatualizadas e tendenciosas”, observa Kalluri. Esta prática levanta preocupações éticas sobre os direitos de autor e a justiça, uma vez que muitas imagens são utilizadas sem a permissão dos criadores originais. Como resultado, os modelos de IA tendem a replicar e perpetuar os preconceitos presentes nos seus dados de treino, limitando a sua capacidade de produzir representações inclusivas e precisas.

Estes sistemas de IA agrupam imagens e conceitos semelhantes com base nos seus dados de treino, restringindo a sua produção à replicação de padrões aprendidos sem a capacidade de inovar ou imaginar para além dos seus conjuntos de dados. Apesar dos esforços de empresas como a OpenAI para atualizar modelos de inclusão, a sua eficácia permanece incerta, como observado por académicos como Roland Meyer, que observaram desafios em levar a IA a gerar representações diversas e precisas sem distorções involuntárias.

Os problemas recentes com o bot Gemini da Google destacam as lutas contínuas com a diversidade e a precisão do conteúdo gerado pela IA. Inicialmente com o objetivo de garantir a diversidade, o Gemini encontrou erros significativos, como deturpar figuras históricas como a tripulação da Apollo 11.

Estes incidentes sublinham as complexidades e os riscos associados à dependência de um único modelo de IA para representar com precisão diversos contextos culturais e históricos. “Kalluri defende uma abordagem descentralizada onde as comunidades locais contribuem para dados de formação em IA adaptados às suas necessidades culturais, defendendo tecnologias que capacitem as comunidades e mitiguem eficazmente os preconceitos.”

Leia o Artigo Original: Science News

Leia mais: A Inteligência Artificial Pode Trazer o Fim da Civilização?